提供者:刘唯

简介

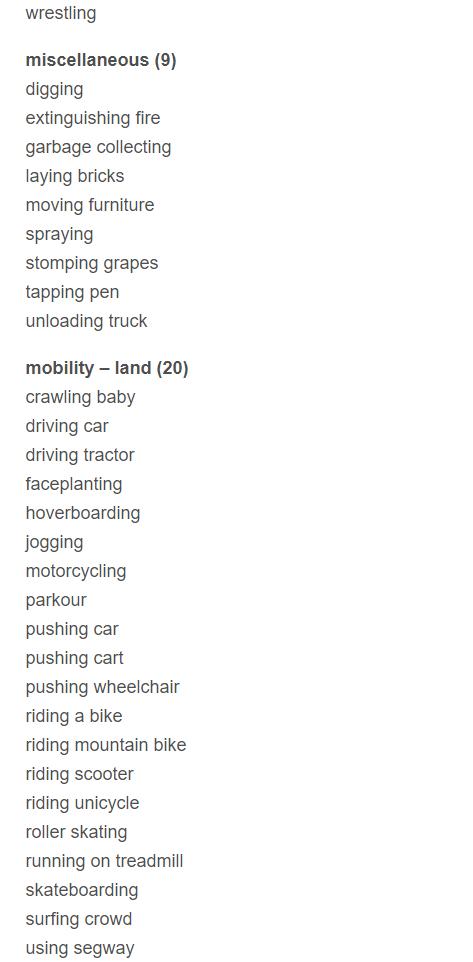

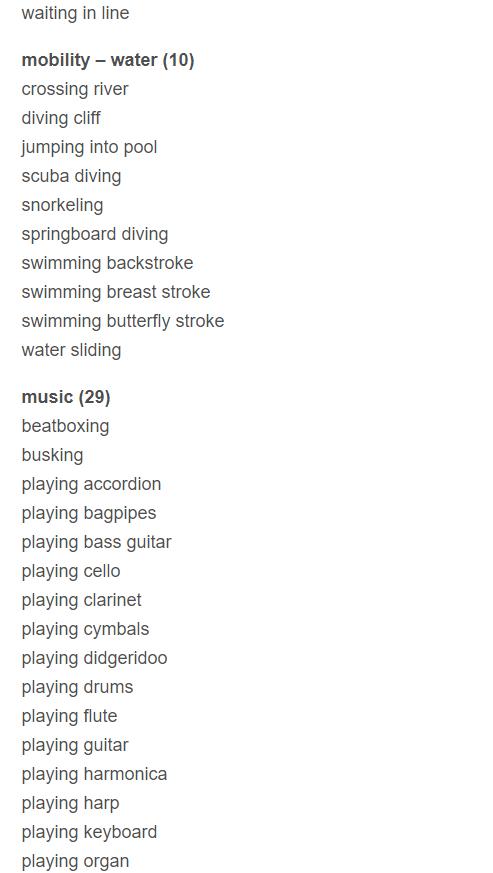

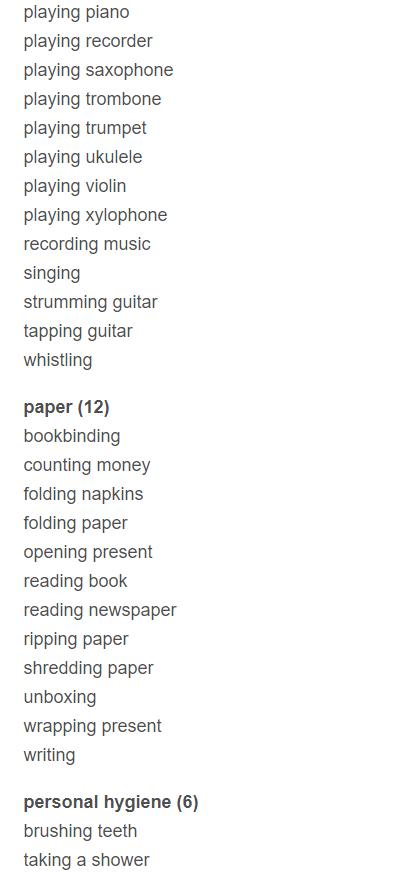

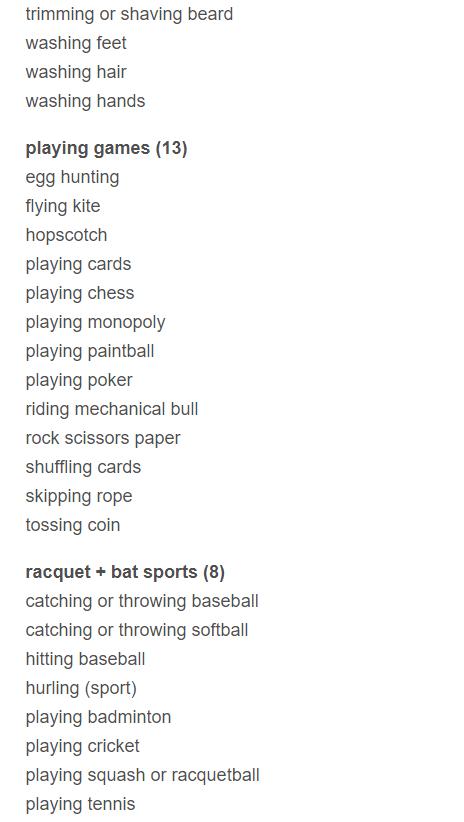

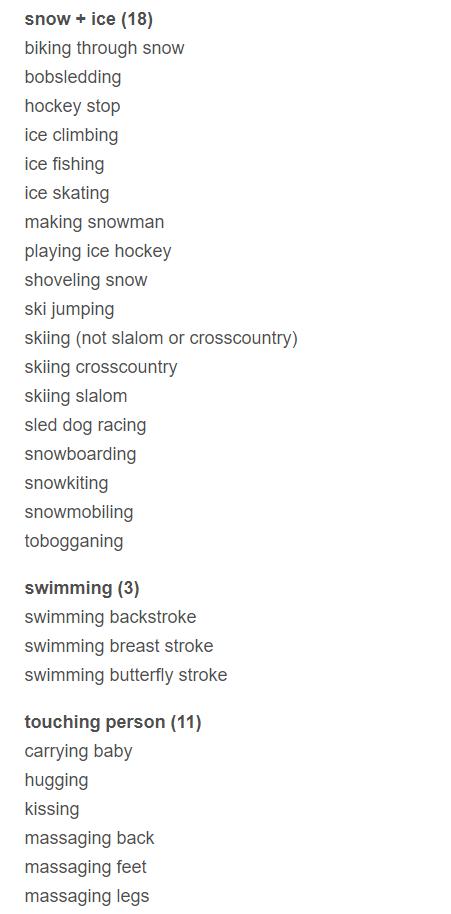

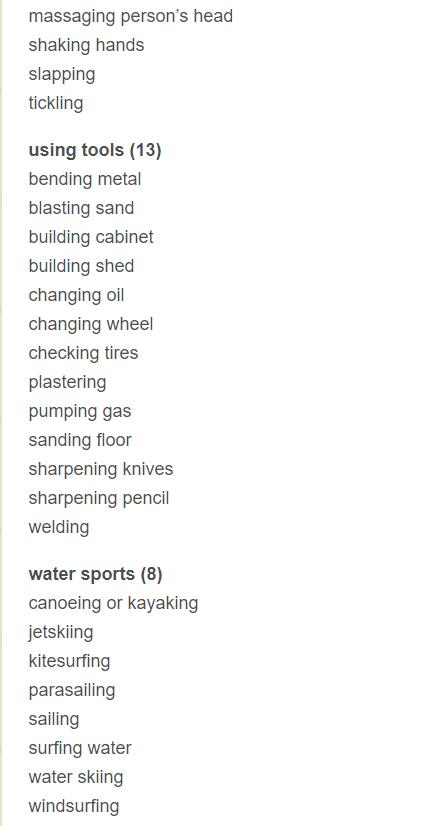

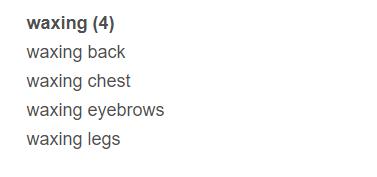

Labelme是斯坦福一个学生的母亲利用休息时间帮儿子做的标注,后来便发展为一个数据集。该数据集的主要特点包括

(1)专门为物体分类识别设计,而非仅仅是实例识别

(2)专门为学习嵌入在一个场景中的对象而设计

(3)高质量的像素级别标注,包括多边形框(polygons)和背景标注(segmentation masks)

(4)物体类别多样性大,每种物体的差异性,多样性也大。

(5)所有图像都是自己通过相机拍摄,而非copy

(6)公开的,免费的

下载

图像如下图所示,需要通过matlab来下载,一种奇特的下载方式。

下载链接为http://labelme2.csail.mit.edu/Release3.0/index.php

相关论文

[1]吉江燕,方挺.基于Labelme的参考图像的手工分割[J].微型机与应用,2015,34(17):49-51+56.

[2]Bryan C. Russell, Antonio Torralba, Kevin P. Murphy, William T. Freeman.International Journal of Computer Vision[J].LabelMe: A Database and Web-Based Tool for Image Annotation.

[3]